La diffusione della GenAI ha introdotto nuove tecnologie, possibilità e rischi. L’adozione dell’intelligenza artificiale sta accelerando in tutti i settori, ma la maggior parte delle organizzazioni si muove più rapidamente dei propri controlli di sicurezza, rendendo la gestione del rischio AI una priorità urgente.

Inoltre, l’adozione dell’AI sta creando nuove superfici di attacco, che emergono da attività come sviluppo software, ricerca, creazione di contenuti, applicazioni ombra e agenti di supporto che, spesso, sono prive di una governance strutturata.

Ancora uno dei rischi più sottovalutati è l’uso quotidiano di strumenti GenAI pubblici come ChatGPT o Gemini. I dipendenti possono, senza volerlo, inserire codice proprietario, documenti interni o credenziali sensibili in questi LLM pubblici, che memorizzano e processano tali dati. Senza politiche adeguate, le organizzazioni rischiano di esporre proprietà intellettuale o dati riservati senza rendersene conto.

Principali rischi Ai a cui le organizzazioni sono esposte

Di seguito i principali rischi scaturiti dall’AI:

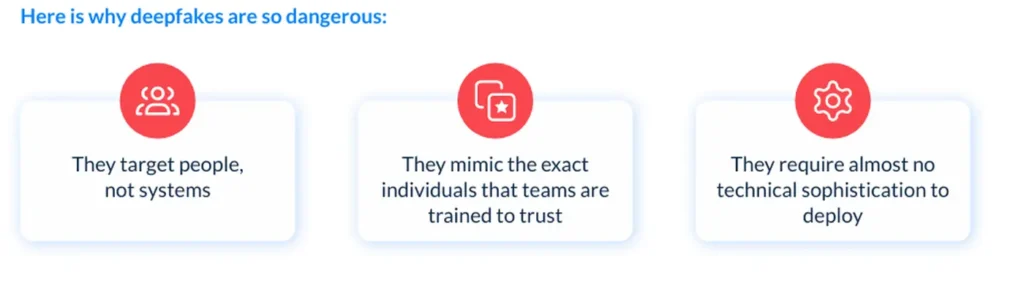

Deepfake – I deepfake rappresentano una minaccia crescente e vengono utilizzati attivamente per truffare aziende e individui su larga scala, manipolando non solo i contenuti ma anche la fiducia delle persone. Tali tecniche avanzate permettono agli aggressori di impersonare dirigenti in video e audio in tempo reale, consentendo l’autorizzazione fraudolenta di transazioni, la manipolazione dei dipendenti e l’aggiramento dei protocolli di verifica.

È doveroso evidenziare che la maggior parte delle organizzazioni non è ancora preparata: mancano controlli specifici contro i deepfake, formazione interna dedicata e procedure di risposta agli incidenti per questa tipologia di minaccia.

Purtroppo, la formazione sulla sensibilizzazione dei dipendenti raramente si concentra sui deepfake. Inoltre, mancano strumenti in grado di rilevare video o audio manipolati, e i processi di verifica dell’identità multicanale sono spesso deboli. Infine, di solito, non esistono protocolli di risposta agli incidenti specifici per attacchi basati sull’impersonificazione.

L’impatto potenziale è notevole e può includere frodi finanziarie, trasferimenti non autorizzati, danni alla reputazione, sanzioni normative e la validazione accidentale di false identità. Per prevenire questi rischi, le aziende dovrebbero applicare controlli finanziari chiari. Ad esempio, richiedere una conferma via SMS dal CFO prima di trasferire i fondi, perché l’approvazione verbale non può più essere sufficiente. Le organizzazioni possono anche acquistare strumenti progettati per rilevare i deepfake prima che causino danni.

Fonte immagini – CYE Report – Uncovering & Mitigating GenAI-Driven Threats (sept 2025)

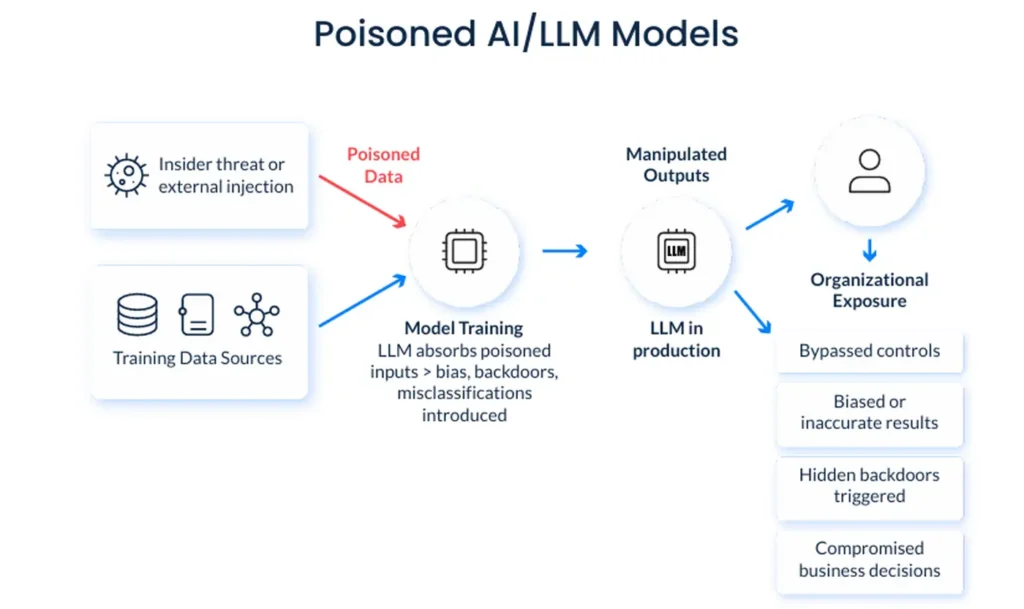

Poisoned AI / LLM Models – I modelli di AI sono validi solo quanto i dati su cui sono addestrati. È proprio questo che li rende un bersaglio. Le possibilità di abuso vanno ben oltre le banalità.

Inoltre, gli attaccanti possono agire sul comportamento del modello per bypassare i controlli, iniettare bias o manipolare il processo decisionale.

Sebbene grandi modelli commerciali come ChatGPT, Claude o Gemini siano generalmente protetti da questo, il rischio è reale negli ambienti di sviluppo interno. Lo scenario più probabile riguarda minacce interne, in cui un dipendente con accesso ai dati di addestramento introduce contenuti dannosi che modificano sottilmente le prestazioni del modello.

Si tratta di cambiamenti difficili da rilevare e che possono persistere inosservati per lunghi periodi.

Inoltre, tali attacchi sono quasi invisibili, persistono nel tempo sono estremamente difficili da invertire una volta dispiegati. Il rischio spesso passa inosservato perché i dati di addestramento raramente vengono auditati o validati. Ancora, gli ambienti di sviluppo mancano di una governance di sicurezza standard. Infine, gli output dell’IA sono spesso considerati senza comprendere come vengono prodotti e non c’è alcun monitoraggio delle prestazioni del modello nel tempo.

Le conseguenze dell’avvelenamento del modello possono includere: decisioni errate, analisi corrotte e risultati distorti o manipolati che comportano rischi legali e reputazionali.

Anche i fornitori più noti possono trascurare vulnerabilità critiche senza test reali. Per prevenire ciò, è fondamentale che le organizzazioni definiscano politiche aziendali rigorose per la validazione dei modelli e delle fonti di formazione. Tale processo deve prevedere test formali sui modelli di terze parti e un controllo approfondito delle fonti di dati utilizzate per l’addestramento.

I responsabili della sicurezza possono anche coinvolgere partner esterni affidabili per i modelli di stress test, anche attraverso tentativi manuali di jailbreak. Ciò è particolarmente importante prima di implementare strumenti di IA negli ambienti di produzione.

Fonte immagini – CYE Report – Uncovering & Mitigating GenAI-Driven Threats (sept 2025)

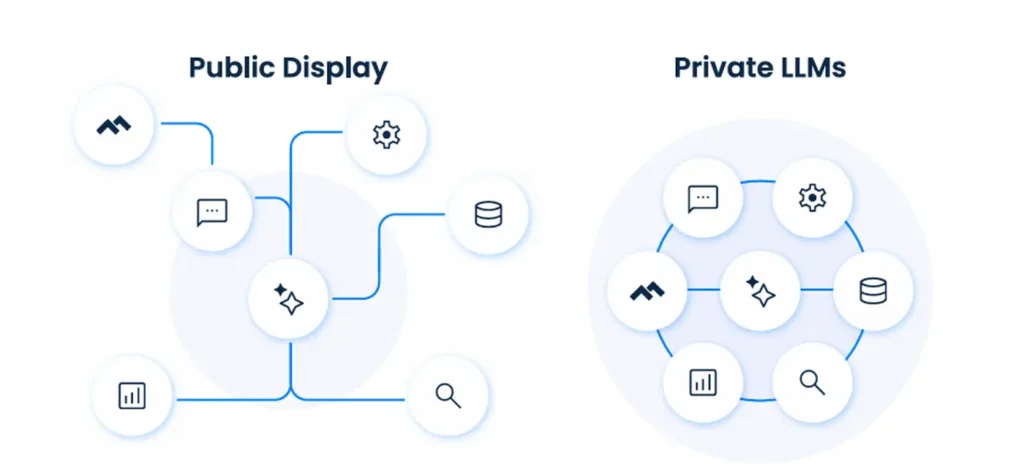

Uso quotidiano dei LLM pubblici – Uno dei rischi più sottovalutati nell’azienda è l’uso quotidiano e non monitorato di LLM pubblici come ChatGPT, Gemini e altri. I dipendenti interagiscono regolarmente con questi strumenti per produttività, generazione di idee o assistenza al codice e, senza politiche/vincoli chiari, potrebbero involontariamente condividere dati sensibili come proprietà intellettuale, strategia interna, dati dei clienti o persino credenziali.

Molte piattaforme LLM pubbliche memorizzano di default prompt e risposte, creando un’esposizione a lungo termine al di fuori del controllo dell’azienda. Inoltre, i team di sicurezza spesso hanno poca o nessuna visibilità su chi utilizza quali strumenti. Le conseguenze dell’uso improprio di LLM pubblici possono includere la perdita di proprietà intellettuale a favore di sistemi di terze parti, la fuga di credenziali o conseguenze legali o normative per la cattiva gestione di dati sensibili.

Le aziende, per mitigare questo rischio, possono stabilire e applicare politiche di utilizzo per gli strumenti GenAI, inclusa la formazione dei dipendenti per comprendere i rischi della condivisione di dati sensibili con l’IA. Inoltre, possono anche investire in LLM di livello privato o enterprise che non memorizzano né addestrano dati aziendali. Ancora, è importante monitorare il traffico in uscita per rilevare eventuali perdite di dati verso endpoint pubblici di IA.

Il monitoraggio può includere la configurazione di strumenti di prevenzione della perdita di dati, l’impostazione del controllo delle uscite a livello di rete e l’utilizzo di broker di sicurezza cloud per monitorare l’uso degli strumenti di AI.

Inoltre, le aziende possono anche implementare ispezioni del traffico consapevoli dell’AI che segnalano prompt contenenti parole chiave o metadati sensibili, garantendo che l’AI venga usata in modo sicuro, con piena visibilità e controllo.

Fonte immagini – CYE Report – Uncovering & Mitigating GenAI-Driven Threats (sept 2025)

AI-Driven Phishing – Gli attacchi di phishing si sono sempre basati sul comportamento umano. La GenAI li rende più veloci, più mirati e molto più convincenti. Gli attaccanti ora utilizzano la generazione di linguaggio naturale e dati in tempo reale per creare messaggi di phishing con contenuti contestuali, creati dall’AI, che risultano urgenti e autentici.

Le difese tradizionali sono carenti perché i filtri email non sono addestrati a riconoscere i contenuti generati dall’AI, e l‘addestramento degli utenti si basa spesso su schemi di phishing obsoleti.

Per prevenire questo tipo di phishing, le organizzazioni hanno bisogno di difese stratificate, non solo di formazione. I dipendenti con ruoli decisionali dovrebbero essere formati a riconoscere messaggi altamente contestuali e richieste fuori schema. Ma questa è solo una parte della soluzione.

Di fatto, i team di sicurezza dovrebbero garantire flussi di lavoro di verifica rigorosi per le richieste finanziarie o relative agli accessi. Ovvero, si tratta di implementare strategie di cybersecurity efficaci per identificare comportamenti email insoliti o cambiamenti di tono. Gli strumenti di verifica dell’identità possono convalidare l’autenticità del mittente. Inoltre, applicare i principi di zero trust alle comunicazioni interne aiuta a limitare l’esposizione; mentre gli strumenti di AI dovrebbero essere utilizzati per monitorare i pattern generativi nel traffico email.

Attacchi adversarial ai sistemi di AI

Le organizzazioni adottano progressivamente sistemi AI-driven per l’implementazione di misure di cybersecurity. Tuttavia, questi sistemi risultano vulnerabili agli attacchi adversarial, caratterizzati dall’iniezione di perturbazioni adversarial (noise crafted) che generano input adversarial specificamente progettati per indurre classificazioni errate nei modelli di machine learning.

Inoltre, tali attacchi presentano caratteristiche percettivamente indistinguibili dagli input legittimi, ma contengono payload malevoli o pattern adversarial che compromettono l’integrità dei dataset di training attraverso tecniche di data poisoning. Sfruttando modelli di AI generativa, gli attaccanti possono orchestrare attacchi multi-stage: il primo livello di AI genera adversarial inputs ottimizzati per ingannare un secondo livello di sistemi AI, provocando output errati o decisioni compromesse nei sistemi target.

La GenAI può essere “weaponizzata” per sintetizzare:

- Immagini adversarial progettate per eludere algoritmi di deep learning in sistemi di computer vision e riconoscimento biometrico.

- Testi adversarial formulati per bypassare sistemi NLP (Natural Language Processing) e content moderation engines

Gli attacchi adversarial compromettono l’affidabilità e robustezza dei sistemi di sicurezza AI-based, creando vulnerabilità sfruttabili che i cyber criminali possono sfruttare per evasion attack e compromissione dei meccanismi di difesa automatizzati.

Perché le minacce dell’AI restano nascoste

L’AI viene utilizzata in tutte le aziende, spesso senza supervisione. Secondo McKinsey, il 71% delle aziende ora utilizza la GenAI in almeno una funzione aziendale, al di fuori della governance. Il risultato è un numero crescente di punti ciechi nel rilevamento del rischio, dato che i team di sicurezza sono focalizzati su infrastruttura, identità e rischio degli endpoint, senza considerare che la GenAI introduce un nuovo livello di esposizione che attraversa dipartimenti, funzioni e dati.

Le barriere comuni alla visibilità includono:

- Uso dell’AI shadow nel marketing, R&S e supporto clienti

- Nessun inventario di strumenti LLM installati o pilotati

- Strumenti di sicurezza che non mappano l’uso dell’IA agli asset aziendali critici

Finché queste lacune non saranno colmate, le minacce legate all’IA rimarranno nascoste.

Migliori pratiche per gestire il rischio GenAI

I responsabile di cybersecurity possono adottare le seguenti best practice per gestire al meglio i rischi derivanti dall’AI e, precisamente:

Rafforzare politiche, formazione e governance – Si consiglia di

- Identificare dove GenAI, LLM e modelli di ML vengono utilizzati all’interno dell’organizzazione. Ciò include sia implementazioni autorizzate sia non autorizzate in dipartimenti come marketing, R&S e supporto clienti.

- Mappare punti di contatto con asset e processi aziendali critici.

- Aggiornare le politiche interne per coprire esplicitamente i deepfake, l’avvelenamento di modelli e il phishing GenAI.

- Stabilire linee guida per l’uso accettabile degli LLM pubblici e assicurarsi che siano supportate da una formazione che utilizzi esempi reali.

- Redigere piani e manuali di risposta agli incidenti su misura per le minacce guidate dall’AI, oltre a chiarire la responsabilità tra le funzioni. È importante che la governance si evolva con la stessa rapidità con cui lo fa l’AI.

Investire negli strumenti giusti per ottenere visibilità e ridurre i rischi – Esistono sul mercato soluzioni in grado di mappare rischi, qualideepfake, phishing, impersonificazione, sfruttamento dei modelli e perdita di dati, oltre cha a rilevare il movimento laterale dei cyber criminali nella rete aziendale e relativi impatti sugli asset i critici.

Inoltre, le piattaforme offrono moduli di analisi comparativa avanzata che consentono di effettuare il confronto differenziale tra le superfici di attacco emergenti – derivanti dall’implementazione di sistemi AI – e le minacce tradizionali persistenti (legacy risks).

Si evidenzia che tali funzionalità implementano algoritmi di filtering e prioritizzazione dei risultati basati su metriche di criticità multilivello, permettendo di quantificare l’impatto economico-finanziario delle vulnerabilità attraverso modelli di risk quantification.

Di fatto, la traduzione delle minacce tecniche in metriche di business impact consente ai Chief Information Security Officer (CISO) di attuare strategie di risk mitigation basate su prioritizzazione data-driven, focalizzandosi sugli asset e le vulnerabilità con maggiore rilevanza per il business.

Conclusione

La GenAI rappresenta una tecnologia trasformativa con capacità senza precedenti, ma introduce – al contempo – nuove superfici di attacco e rischi di sicurezza emergenti che richiedono un approccio strategico da parte delle organizzazioni.

Pertanto, l’adozione sicura ed efficace della GenAI dipende dalla consapevolezza dei rischi e dall’implementazione di strategie di hardening e framework di sicurezza robusti. Solo attraverso un approccio proattivo alla sicurezza le organizzazioni potranno sfruttare appieno il potenziale innovativo della GenAI, massimizzando i benefici aziendali e minimizzando l’esposizione a minacce cyber.

Inoltre, a fronte dell’evoluzione continua di questa tecnologia, è imperativo che le organizzazioni mantengano un aggiornamento costante su misure di sicurezza avanzate e best practice emergenti, oltre a garantire la gestione delle criticità di sicurezza che richiedono competenze specialistiche e governance adeguata a essere efficacemente mitigate.

Cybsec-news.it vi invita alla terza edizione della CYBSEC-EXPO, in programma a Piacenza dal 9 all’11 Giugno 2026.